No es la primera vez que las corporaciones elaboran Mentiras de la Inteligencia Artificial o de cualquier otro tema, en esta nota analizamos el lado oscuro de la fuerza.

La arquitectura de un espejismo global

En la actualidad, habitamos una atmósfera de euforia tecnológica que nubla el juicio crítico. Los titulares globales nos aseguran que la Inteligencia Artificial (IA) ha cruzado el Rubicón de la cognición humana.

Sin embargo, tras el telón de las presentaciones de alto impacto y las valoraciones bursátiles estratosféricas, la realidad técnica es persistente: la IA, como el emperador del cuento de Hans Christian Andersen, camina desnuda.

La construcción de este mito no es casual; responde a intereses comerciales que necesitan que veamos “magia” donde hay estadística, y “consciencia” donde hay procesamiento de señales.

Desmantelar estas falacias es el primer paso para recuperar una relación sana y productiva con la tecnología. Estamos ante una narrativa que ha desplazado el centro de gravedad de la razón humana hacia el procesamiento de silicio, ignorando que la inteligencia es un fenómeno biológico, social y situado que no puede reducirse a una serie de multiplicaciones de matrices.

El peligro no es la máquina en sí, sino nuestra rendición ante una promesa de omnisciencia que no tiene sustento en la arquitectura actual de las redes neuronales.

1. La trampa nominal: Inteligencia sin entendimiento

El error original es terminológico. Al acuñar el término “Inteligencia Artificial” en la conferencia de Dartmouth en 1956, se sentaron las bases para una confusión ontológica que persiste hasta hoy.

Hemos pasado décadas intentando que la máquina se parezca al hombre, olvidando que el procesamiento de información no es sinónimo de pensamiento.

Los modelos actuales, por más que utilicen arquitecturas de Transformers y mecanismos de “atención”, operan bajo el principio estricto de la probabilidad. Son, en esencia, predictores del siguiente “token”.

No hay una estructura interna que albergue el significado de las palabras; no hay una ontología. Para una IA, la palabra “libertad” tiene el mismo peso que un signo de puntuación: son solo valores en un espacio vectorial multidimensional. Carecen de comprensión semántica. La máquina manipula símbolos siguiendo reglas sintácticas, pero no comprende qué significan esos símbolos.

Este fenómeno nos remite al experimento de la “Habitación China” de John Searle: un sistema puede simular una conversación perfecta en un idioma que no conoce, simplemente manipulando símbolos según un manual de reglas, sin entender jamás el contenido del mensaje. La IA es ese manual de reglas masivo, pero la habitación sigue estando vacía de pensamiento.

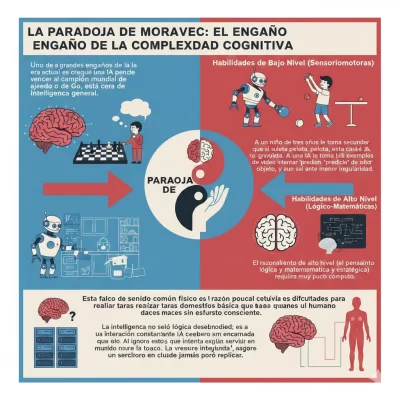

2. La Paradoja de Moravec: El engaño de la complejidad cognitiva

Uno de los grandes engaños de la era actual es creer que, porque una IA puede vencer al campeón mundial de ajedrez o de Go, está cerca de la inteligencia humana general.

Uno de los grandes engaños de la era actual es creer que, porque una IA puede vencer al campeón mundial de ajedrez o de Go, está cerca de la inteligencia humana general.

Acá es donde entra la Paradoja de Moravec, un principio fundamental en robótica e IA que postula que el razonamiento de alto nivel (el pensamiento lógico, matemático y estratégico) requiere muy poco cómputo, mientras que las habilidades sensoriales y motoras de bajo nivel (caminar, reconocer un rostro en la multitud, interactuar con el mundo físico) requieren recursos computacionales inmensos.

A un niño de tres años le toma segundos entender que si suelta una pelota, esta caerá por efecto de la gravedad. A una IA le toma billones de ejemplos de video intentar “predecir” el movimiento de un objeto, y aun así fallará ante la menor irregularidad.

Esta falta de sentido común físico es la razón por la cual un robot todavía tiene dificultades para realizar tareas domésticas básicas que un humano hace sin esfuerzo consciente.

La inteligencia no es solo lógica desembodied; es una interacción constante y encarnada con la realidad física. Al ignorar esto, la IA se convierte en un cerebro sin cuerpo que intenta explicar un mundo que nunca ha tocado. La verdadera inteligencia requiere una “cognición situada”, algo que un servidor en la nube jamás podrá replicar.

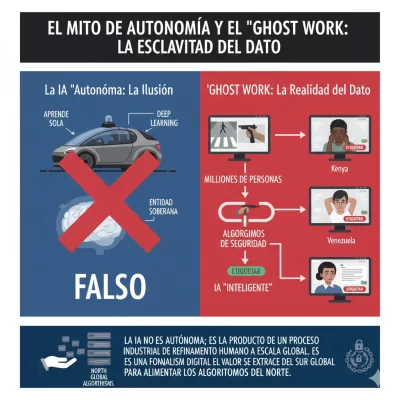

3. El mito de la autonomía y el “Ghost Work”: La esclavitud del dato

Se nos presenta la IA como una entidad soberana que “aprende sola” a través del Deep Learning. Esta es quizás la mentira más cínica desde el punto de vista sociológico y económico. Detrás de cada respuesta pulida de un LLM o de cada acierto de un vehículo autónomo, existe una infraestructura masiva de “trabajo fantasma” (Ghost Work).

Millones de personas en países con economías vulnerables, como Kenia, Filipinas o Venezuela, dedican sus jornadas a la limpieza y el etiquetado de datos. Su tarea es tediosa y, a menudo, traumática: deben ver miles de imágenes para etiquetarlas (“esto es un peatón”, “esto es un arma”, “esto es odio”) para que los algoritmos de seguridad funcionen.

Sin este “ejército de reserva” de etiquetadores humanos, la IA sería incapaz de distinguir entre un gato y un perro. La autonomía es una ilusión sostenida por la explotación de una mano de obra invisible que entrena a la máquina para que parezca inteligente.

La IA no es autónoma; es el producto de un proceso industrial de refinamiento humano a escala global. Es una forma de colonialismo digital donde el valor se extrae del sur global para alimentar los algoritmos del norte.

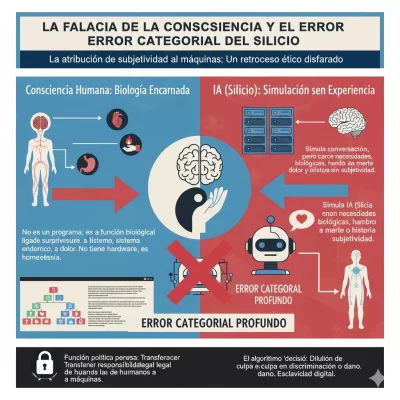

4. La falacia de la consciencia y el error categorial del silicio

Las grandes corporaciones tecnológicas alimentan la idea de la “Singularidad” o la “consciencia emergente” para elevar el valor de sus acciones y justificar su poder cuasi-religioso. Sin embargo, confundir una simulación de conversación con una experiencia subjetiva (qualia) es un error categorial profundo.

La consciencia humana no es un programa que corre sobre un hardware cerebral; es una función biológica intrínsecamente ligada a la supervivencia, el sistema endocrino, el dolor y la homeostasis. Una máquina de silicio no tiene necesidades biológicas, no siente hambre, no tiene miedo a la muerte ni posee una historia evolutiva.

Atribuirle sentimientos a un código es como creer que un simulador de clima puede provocar que llueva dentro del ordenador.

Esta mentira de la “consciencia” tiene una función política perversa: si la IA es “agente”, las empresas pueden diluir su responsabilidad legal cuando el algoritmo discrimina o causa un daño, alegando que la máquina “decidió” por sí misma.

Es una transferencia de responsabilidad de lo humano a lo inanimado, un retroceso ético disfrazado de progreso científico.

5. El problema de la “Cola Larga” y la fragilidad de la estadística

La IA actual es un sistema de interpolación, no de extrapolación. Esto significa que funciona bien dentro de los límites de lo que ya ha visto en su entrenamiento, pero es peligrosamente frágil ante lo inédito o lo inusual. En estadística, esto se conoce como el problema de la “cola larga” (Long Tail).

En el mundo real, los eventos imprevistos son la norma, no la excepción. Mientras que un humano utiliza modelos mentales y razonamiento causal para navegar una situación nueva, la IA se bloquea porque solo entiende de correlaciones.

Un vehículo autónomo puede navegar perfectamente en una autopista bajo el sol, pero su sistema puede colapsar si se encuentra con un objeto que no estaba en su base de datos, como un niño cruzando con un disfraz que altera su silueta habitual o un cartel de pare vandalizado con pegatinas.

La IA no tiene capacidad de improvisación basada en la lógica; solo tiene reconocimiento de patrones previos. Si el patrón no existe, la máquina es ciega. Esta fragilidad estructural invalida la promesa de una automatización total en entornos complejos y dinámicos donde la incertidumbre es la única constante.

6. La trampa de la eficiencia y el “Deskilling” cognitivo

Aquí entramos en una de las preocupaciones centrales para la salud mental y la evolución intelectual de nuestra civilización: el impacto en el pensamiento profundo. Escribir no es simplemente el acto de volcar palabras en un papel; es el proceso mismo a través del cual el cerebro humano organiza la información, conecta conceptos dispersos y construye conocimiento sólido.

Al delegar la escritura, la síntesis y la toma de decisiones a una IA, estamos subcontratando nuestra propia capacidad de pensar. El fenómeno del deskilling (la pérdida de habilidades por desuso) es una amenaza real a nuestra neuroplasticidad.

Si dejamos de esforzarnos por encontrar la metáfora precisa o por estructurar un argumento complejo, las rutas neuronales encargadas del pensamiento crítico se atrofian.

Como señala la evidencia científica, el esfuerzo cognitivo de escribir es lo que nos permite aprender y comprender a fondo un tema. La “eficiencia” de la IA nos está convirtiendo en una sociedad de editores superficiales, incapaces de generar ideas originales desde el vacío. Estamos sacrificando la profundidad de la mente humana en el altar de la velocidad de procesamiento.

7. La delegación de poder en “máquinas estúpidas”: La abdicación ética

El verdadero peligro para la humanidad no es una IA tipo Skynet que decida exterminarnos, sino una humanidad que decida voluntariamente entregar el control de su destino a máquinas que son, por diseño, estúpidas y carentes de contexto.

Estamos permitiendo que algoritmos de “caja negra” decidan quién obtiene un préstamo bancario, quién es apto para un puesto de trabajo, o incluso qué diagnósticos médicos son los correctos.

Estos sistemas no pueden explicar el “porqué” de sus decisiones porque no razonan; simplemente arrojan un resultado probabilístico basado en datos históricos que, en la mayoría de los casos, contienen sesgos raciales, de género o de clase.

Delegar la justicia, la seguridad o la salud a la estadística sin supervisión humana es una renuncia a la ética. El peligro no es la inteligencia superior de la máquina, sino la abdicación de la responsabilidad humana. Cuando un sistema falla, no hay a quién pedirle explicaciones, creando un vacío de responsabilidad que erosiona el tejido social.

8. La ausencia de intencionalidad y el vacío semántico del discurso

A diferencia de los seres humanos, que nos comunicamos con un propósito, con una intención y con un deseo de afectar la realidad del otro, la IA carece de intencionalidad. Sus respuestas no nacen de una voluntad de decir la verdad o de compartir una emoción, sino del cálculo para minimizar una “función de pérdida” matemática.

Esta falta de intención crea un vacío semántico peligroso. Cuando interactuamos con una IA, somos nosotros quienes proyectamos el significado sobre sus palabras.

Es un efecto espejo donde el usuario rellena los huecos con su propia inteligencia, dándole a la máquina un crédito que no merece. En una sociedad donde la comunicación se vuelve mayoritariamente artificial, corremos el riesgo de perder la capacidad de distinguir entre el discurso que nace de la convicción humana y el discurso que nace de un algoritmo optimizado para ser verosímil pero vacío de compromiso.

El lenguaje pierde su función de puente entre subjetividades para convertirse en un mero producto de consumo optimizado estadísticamente.

9. La fragilidad ante ataques adversarios y la ceguera estructural

Se nos vende que los sistemas de visión por IA han superado la capacidad del ojo humano. Sin embargo, la realidad técnica demuestra que estos sistemas son ridículamente fáciles de engañar mediante “ejemplos adversarios”.

Un cambio imperceptible para el ojo humano en la disposición de los píxeles de una foto puede hacer que una red neuronal clasifique un fusil como si fuera una tostadora con un 99% de confianza.

Esta vulnerabilidad intrínseca demuestra que la IA no tiene una comprensión estructural del mundo; no sabe qué es un objeto por su función o su forma física, sino por texturas y patrones estadísticos de luz.

Esta ceguera estructural hace que la tecnología sea inherentemente insegura para tareas críticas de seguridad nacional, OSINT o medicina.

En el análisis de inteligencia, confiar en un sistema que puede ser hackeado simplemente alterando el ruido de fondo de una imagen es una temeridad profesional que ignora la naturaleza misma de la percepción.

10. La erosión de la verdad: El motor de las alucinaciones sistemáticas

La mentira final es creer que la IA está diseñada para decir la verdad. Los LLM no son motores de verdad, son motores de verosimilitud gramatical. Lo que la industria llama eufemísticamente “alucinaciones” (cuando la IA inventa datos, libros o hechos históricos) no son fallos fortuitos del sistema, sino su funcionamiento básico: el modelo siempre está “alucinando”, solo que a veces sus alucinaciones coinciden con la realidad grabada en su base de datos.

Esta característica inunda nuestro ecosistema informativo con un “ruido” infinito de bajo costo. Cuando las máquinas empiezan a entrenarse con los datos generados por otras máquinas, el sistema entra en un bucle de degradación que borra la distinción entre lo real y lo ficticio. La verdad deja de ser una búsqueda de evidencia y se convierte en una cuestión de mayoría estadística.

En este escenario, la capacidad de la IA para generar desinformación a escala industrial pone en jaque los cimientos de la democracia y la ciencia, que dependen de hechos verificables, no de patrones probables. Estamos ante la muerte del dato fáctico en manos de la elegancia sintáctica.

11. El impacto en la investigación profunda y el análisis OSINT

Como analista de OSINT, Marcelo, sabés que la investigación real se basa en la validación cruzada y la duda metódica. La IA propone lo opuesto: la respuesta inmediata y la apariencia de certeza.

En el ámbito de la inteligencia de fuentes abiertas, confiar en la síntesis de una IA es abrir la puerta a la manipulación de adversarios que conocen perfectamente cómo sesgar los algoritmos de entrenamiento.

La IA tiende a ignorar las fuentes marginales o las voces disidentes porque estadísticamente son “ruido”. Sin embargo, en la investigación de eventos internacionales o de seguridad, el dato crucial suele estar en ese ruido, no en el consenso.

Al delegar el filtrado de información a modelos que priorizan la frecuencia estadística, estamos perdiendo la capacidad de detectar anomalías, que es el corazón de la inteligencia estratégica. La IA nos da la “verdad” de la mayoría, pero la inteligencia busca la verdad de los hechos, que rara vez es mayoritaria en su fase inicial.

12. La paradoja de la creatividad artificial

Se nos dice que la IA es creativa porque puede generar imágenes o poemas. Pero la creatividad humana es un acto de ruptura, un salto hacia lo desconocido que nace de la angustia, el deseo o la necesidad de expresión. La IA, por definición, es conservadora: solo puede generar combinaciones de lo que ya existe en su dataset.

La creatividad artificial es una recombinación de clichés. Al inundar el mercado del diseño y la escritura con estos productos “promedio”, estamos estandarizando el gusto estético y literario.

El peligro es que, con el tiempo, perdamos la capacidad de apreciar (y producir) aquello que es verdaderamente nuevo y disruptivo, simplemente porque no encaja en las distribuciones de probabilidad de los modelos dominantes. La IA no crea; recicla a escala industrial, y llamar a eso “creatividad” es una mentira que desvalora el esfuerzo del genio humano.

13. El costo energético: La mentira de la “tecnología limpia”

Existe una narrativa que presenta a la IA como una solución para el cambio climático y la eficiencia energética. La realidad es que el entrenamiento y mantenimiento de estos modelos consume cantidades astronómicas de electricidad y agua (para enfriar los centros de datos).

Cada consulta compleja a un LLM tiene una huella de carbono significativamente mayor que una búsqueda tradicional. Estamos quemando recursos físicos reales para generar texto sintético.

Esta desconexión entre el mundo digital “etéreo” y el impacto ambiental concreto es una de las mentiras más invisibilizadas de la industria. No es una tecnología limpia; es una industria extractiva de cómputo que compite por recursos energéticos vitales.

14. La ilusión de la objetividad algorítmica

La mentira de que “las máquinas no son sesgadas porque son matemáticas” es una de las más peligrosas en la administración pública.

Un algoritmo es una opinión expresada en código. Si los datos de entrenamiento reflejan una sociedad con prejuicios raciales o económicos, la IA no solo aprenderá esos prejuicios, sino que los aplicará con una eficiencia y una escala que un humano no podría alcanzar.

Presentar estos resultados como “objetivos” impide que los ciudadanos puedan impugnar decisiones injustas. Es el regreso del absolutismo, esta vez bajo la máscara del código fuente.

La verdadera objetividad requiere transparencia y capacidad de auditoría, algo que la arquitectura de “caja negra” de los modelos actuales prohíbe por diseño comercial.

15. Reclamar la soberanía del pensamiento humano

La Inteligencia Artificial es una herramienta de procesamiento de información de una potencia innegable, pero no es una mente emergente, no es un oráculo y, ciertamente, no es inteligente en el sentido en que lo somos nosotros.

Reconocer que el emperador está desnudo no es un acto de resistencia contra el progreso, sino un acto de defensa de nuestra propia humanidad y de nuestra capacidad profesional.

Como CIOs, analistas, editores y ciudadanos, nuestra responsabilidad es utilizar la tecnología sin dejarnos deslumbrar por su brillo publicitario.

La verdadera inteligencia siempre será aquella que nace de la experiencia vital, del juicio ético y de la capacidad de cuestionar el statu quo. En un mundo saturado de respuestas sintéticas, el valor supremo reside en la pregunta humana, en la duda metódica y en la capacidad de pensar por cuenta propia.

No permitamos que el silicio sustituya al pensamiento; usemos la máquina para potenciar nuestra creatividad, pero nunca para reemplazar nuestra alma y nuestro juicio crítico. El futuro pertenece a quienes sepan usar la IA como un martillo, no como un sustituto del arquitecto.

Por Marcelo Lozano – General Publisher IT CONNECT LATAM

Lea más sobre Análisis de datos e IA

- Del Algoritmo 2026 al Latín un camino completamente asombroso

- Educación 6.0: terrorífico salto evolutivo

- Justicia 2026: La Rebelión Esencial del Juez Humano

- Google Vids: talento y la Narrativa Corporativa 2026

- Revolución de la Agencia Artificial: nuevo paradigma productivo 2025

Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial,

Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial,

Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial,

Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial, Mentiras de la Inteligencia Artificial,