La última trinchera de lo humano: Justicia, dolor y la agonía de lo real en la era sintética

Comencemos con una provocación, una pregunta que últimamente resuena con la fuerza de un sacrilegio en los pasillos de la academia y las corporaciones:

¿Qué sentido tiene hoy pagar 70.000 dólares al año por un posgrado en Harvard?

Si el objetivo es estrictamente la “transferencia de conocimiento” —esa inyección de datos, técnicas y marcos teóricos en el cerebro del estudiante—, la respuesta es brutalmente honesta: ninguno.

Estamos presenciando una divergencia histórica entre la curva de adquisición de conocimiento humano, que es lineal, costosa y lenta, y la curva de conocimiento sintético, que es exponencial y de costo marginal cero.

Hoy, una Inteligencia Artificial Generativa bien dirigida puede resumir, sintetizar y aplicar la bibliografía completa de un MBA en segundos. Si definimos la educación como el mero acceso a la información, la universidad ha muerto y la IA es el nuevo rey. Sin embargo, seguimos pagando esas matrículas exorbitantes.

¿Por qué? Porque intuitivamente sabemos que, en un mundo inundado de respuestas sintéticas baratas, lo que compramos ya no es el “saber”, sino el “ser”. Pagamos por el roce humano, por el capital social y, sobre todo, por el entrenamiento en aquello que la máquina no puede replicar: la gestión de la incertidumbre, la fricción ética y el peso de la responsabilidad.

Pero esta lógica de mercado educativo es solo el síntoma de un terremoto mucho mayor.

Estamos ante un tsunami de conocimiento sintético que amenaza con romper los diques de todas nuestras instituciones de autoridad, desde la cátedra universitaria hasta el estrado judicial.

La “democratización” de la inteligencia que promete la IA trae consigo un precio oculto: la obsolescencia de la mediación humana. Y es en el ámbito de la Justicia donde este drama cobra su dimensión más trágica y urgente.

El Espejo Roto y el Infierno de lo Igual

La sala del tribunal contemporáneo, otrora un bastión sagrado de la verdad factual y la deliberación humana, se encuentra hoy asediada por una fuerza ontológica que amenaza con desmantelar su propia esencia.

No se trata simplemente de una crisis de congestión burocrática o de sesgo humano, problemas que han aquejado a la justicia desde sus inicios. Nos enfrentamos a una crisis metafísica provocada por la ascensión de la Superinteligencia y la omnipresencia de lo sintético.

Vivimos, como diría el filósofo Byung-Chul Han, en el “infierno de lo igual”. La tecnología digital, en su afán de transparencia y eficiencia, detesta la singularidad.

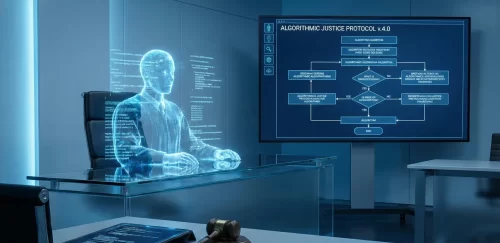

El sistema judicial tradicional se basaba en el encuentro con el “Otro”: ese individuo opaco, complejo y único que se sentaba en el banquillo. Pero la IA no ve personas; ve patrones.

Cuando sometemos a un acusado al escrutinio de algoritmos de justicia predictiva o herramientas de evaluación de riesgo, lo estamos despojando de su biografía única para convertirlo en un perfil de datos.

Transformamos la singularidad del caso en una generalidad estadística. Aquí reside la violencia de la positividad: el acusado es juzgado no por sus actos, sino por su similitud matemática con un agregado de datos históricos.

La IA, por definición, no puede encontrar al “Otro”, solo reconoce lo “Mismo” repetido en diferentes configuraciones.

Si permitimos que esta lógica colonice nuestros tribunales en nombre de la eficiencia, el juicio deja de ser un encuentro ético entre dos subjetividades (juez y acusado) para convertirse en una operación administrativa de clasificación de objetos.

Y un sistema que clasifica objetos no imparte justicia; administra inventario.

La Vergüenza Prometeica del Juez

¿Por qué, entonces, los jueces y juristas parecen tan dispuestos a ceder terreno ante la invasión algorítmica? ¿Por qué aceptamos que una “caja negra” nos dicte sentencias probabilísticas?

La respuesta no está en la pereza, sino en lo que Günther Anders diagnosticó proféticamente como “vergüenza prometeica”. Es la humillación que siente el creador ante la calidad superior de sus propias criaturas.

Frente a una máquina que puede procesar millones de páginas de jurisprudencia en un parpadeo, que no se cansa, que no tiene hambre y que (aparentemente) no tiene prejuicios, el ser humano se percibe a sí mismo como “mal hecho”.

El juez humano se sabe limitado por la biología. Sabe que se cansa, que su atención fluctúa, que sus emociones pueden nublar su razón. Al mirar al algoritmo, siente una inferioridad técnica que deviene en crisis existencial.

Comienza a verse a sí mismo como un “factor de riesgo”, un eslabón débil biológico que introduce error en un proceso que podría ser perfecto.

Esta vergüenza conduce a una “rendición silenciosa”. El juez abdica de su soberanía no porque confíe ciegamente en la máquina, sino porque desconfía profundamente de sí mismo.

Prefiere delegar la decisión en la herramienta de evaluación de riesgos, convirtiéndose en un mero operario que valida el output de la norma automatizada. Es la fantasía de convertirse en un engranaje más de la maquinaria para dejar de sufrir la carga de ser falible.

El Colapso de la Verdad y el Dividendo del Mentiroso

Pero si la crisis del juez es interna, la crisis de la evidencia es externa y total. La irrupción de la IA Generativa y los deepfakes nos ha precipitado a un escenario que Jean Baudrillard describiría como el crimen perfecto: la eliminación de la realidad misma.

Hasta ayer, el sistema legal operaba bajo la presunción de que una fotografía o una grabación eran índices de la realidad, rastros físicos de un evento.

Hoy, un video generado por IA no es una alteración de la realidad; es una creación ex nihilo, un simulacro puro que es su propia verdad.

Esto nos lleva a una crisis técnica y epistemológica sin precedentes: la ruptura de la Cadena de Custodia. ¿Cómo garantizamos la veracidad de una prueba digital cuando existen agentes generativos capaces de crear no solo la imagen falsa, sino todo el rastro de metadatos, correos electrónicos y registros GPS que la respaldan?.

El resultado práctico es aterrador: el “Dividendo del Mentiroso” (Liar’s Dividend).

En un entorno saturado de falsificaciones perfectas, cualquier actor culpable puede alegar que una evidencia real y condenatoria es, de hecho, un deepfake. El escepticismo corrosivo inunda la sala. El juez se encuentra en una parálisis epistémica: si admite la evidencia, arriesga condenar con una mentira; si la descarta, arriesga la impunidad basada en la duda tecnológica.

Ante este diluvio de irrealidad, surge la “Apatía de la Realidad”. Los actores judiciales, abrumados por la imposibilidad de discernir, pueden simplemente rendirse y dejar de juzgar hechos para empezar a juzgar “plausibilidad narrativa”.

El juicio se convierte en crítica de cine: no evaluamos la verdad, sino la verosimilitud de la película que nos presentan.

La Gubernamentalidad Algorítmica: El fin del Sujeto

Este desplazamiento nos lleva a un cambio tectónico en la forma de ejercer el poder, lo que Antoinette Rouvroy llama “Gubernamentalidad Algorítmica”.

El derecho tradicional operaba a través de normas que un sujeto consciente podía decidir obedecer o transgredir. El nuevo régimen opera a través de señales y predicciones. No le interesa lo que el sujeto dice o piensa, ni siquiera lo que ha hecho, sino lo que los datos indican que hará.

Utilizando Big Data, el sistema busca “actualizar lo virtual”: castigar o prevenir el crimen antes de que ocurra, basándose en la probabilidad estadística.

Esto es la muerte de la presunción de inocencia y, más grave aún, la muerte de la libertad. Si el sistema me juzga por mi perfil de riesgo y no por mis actos, elimina la posibilidad de que yo actúe de manera diferente a mi pasado. El sujeto deja de ser juzgado por lo Real para ser juzgado por lo Sintético.

Y lo más perverso es que estas decisiones son tomadas por “Cajas Negras” ininteligibles. Cuando un juez firma una sentencia basada en una puntuación de riesgo que ni él ni el acusado pueden comprender (porque es propiedad intelectual de una empresa o fruto de una red neuronal opaca), está violando el derecho fundamental a una decisión razonada.

El juez se convierte en un ventrílocuo de una lógica que ignora.

Elogio del Dolor: La última trinchera

Ante este panorama desolador, donde la eficiencia y la tecnología parecen haber ganado la batalla, ¿qué nos queda? ¿Cuál es la función del humano en el sistema de justicia del futuro?

La respuesta es contraintuitiva: nuestra función es ser ineficientes. Nuestra función es sufrir.

La narrativa tecno-optimista nos vende la idea de que la IA liberará a los jueces del “trabajo sucio” de revisar evidencias traumáticas. Pero esa visión ignora la naturaleza visceral de la justicia.

El juez es un “devorador de pecados” moderno; debe absorber el trauma social para procesarlo y devolverlo en forma de orden. Ese sufrimiento no es un fallo del sistema; es epistemológicamente necesario. Como nos recuerda Han, “el dolor es el umbral”. Sin la negatividad del dolor, no hay comprensión verdadera del otro.

Una IA puede clasificar imágenes de atrocidades sin pestañear, porque procesa píxeles, no dolor moral. Es una máquina anestésica. Pero una justicia anestesiada es una monstruosidad. Representa la “banalidad de la optimización”: la capacidad de administrar castigos terribles con indiferencia absoluta.

La última trinchera del juez humano no está en competir con la máquina en velocidad de procesamiento. Está en su capacidad de ser herido por la realidad. Un juez que ya no siente el peso de sus decisiones, protegido por el filtro aséptico de la pantalla, ha dejado de ser un garante de la justicia para convertirse en un administrador de crueldad eficiente.

La Imposibilidad del Perdón Automatizado

Finalmente, llegamos al argumento definitivo contra la automatización total: el problema del tiempo y el perdón.

Hannah Arendt situó la dignidad humana en la “Natalidad”: la capacidad de comenzar algo nuevo, de romper la cadena de causalidad. El ser humano es una potencia de futuro no determinado. La IA, por el contrario, es una máquina de predicción basada en el pasado. Asume axiomáticamente que el futuro será como el pasado.

Para el algoritmo, el acusado es la suma inmutable de sus datos históricos. No hay espacio para la conversión, el arrepentimiento o el cambio radical, porque esos son “datos atípicos” que el modelo descarta. Una justicia automatizada es ontológicamente incapaz de reconocer la libertad humana porque niega la posibilidad de que seamos diferentes a nuestro historial de búsqueda o nuestros antecedentes penales.

Y, sobre todo, la máquina no puede perdonar. El código digital es el reino de la memoria perfecta y la irreversibilidad absoluta. En la blockchain, el dato nunca se olvida. El perdón, como señalan Arendt y Ricoeur, es la facultad difícil de “desatar al agente del acto”, de permitir el olvido reservado. El algoritmo es la venganza automatizada del pasado; solo puede “actualizar pesos”, no puede dispensar misericordia.

La misericordia es, por definición, una suspensión de la regla basada en la empatía y en el reconocimiento de la vulnerabilidad compartida. La IA es invulnerable; no puede imaginarse a sí misma en el banquillo. Por lo tanto, no puede perdonar. Solo puede dictar error o cumplimiento.

Aquí tienes una continuación de aproximadamente 500 palabras, manteniendo el tono filosófico, reflexivo y humanista del texto original, diseñado para profundizar en las implicaciones de este “nuevo contrato social” entre el juez y el algoritmo.

La Resistencia Cognitiva y el Derecho a la Fricción

Esta rebelión no implica un ludismo ciego ni el rechazo a la herramienta que nos libera del tedio burocrático. Implica, más bien, comprender que la eficiencia aséptica es una trampa mortal para la democracia. El mercado tecnológico nos vende la idea de una justicia sin fricción: resoluciones instantáneas, predicciones de reincidencia con un 99% de precisión estadística y despachos limpios de expedientes. Pero debemos recordar que la justicia necesita fricción. Necesita el tiempo muerto de la deliberación, el insomnio del juez ante una decisión difícil y la incomodidad de la duda razonable.

Una justicia sin fricción, automatizada a la velocidad de la luz, elimina el espacio vital donde ocurre la interpretación moral. Si delegamos el juicio al cálculo probabilístico, convertimos al acusado no en un sujeto de derechos, sino en un punto de datos dentro de una tendencia histórica.

Y aquí radica el peligro existencial: la estadística es la ciencia del pasado; la justicia debe ser la arquitectura del futuro. Un algoritmo condenará a un joven basándose en lo que hicieron otros jóvenes en sus circunstancias ayer; un juez humano tiene la potestad de mirar a ese joven a los ojos y apostar por quién podría llegar a ser mañana. Esa apuesta, irracional para la máquina, es la esencia de la reinserción y la esperanza.

El Nuevo Currículo de la Magistratura

Por tanto, la formación jurídica debe sufrir una metamorfosis violenta. Aquellos 70.000 dólares de matrícula no deben destinarse a memorizar códigos que una IA puede recitar en nanosegundos, ni a aprender jurisprudencia que un motor de búsqueda puede correlacionar mejor que cualquier mente brillante. La educación del jurista del siglo XXI debe centrarse en la “Ingeniería de la Empatía” y la “Auditoría de Contexto”.

El juez del futuro será, ante todo, un filósofo pragmático y un guardián de la excepción. Su trabajo comenzará precisamente donde la IA se detiene: en los casos borde, en los “cisnes negros”, en las tragedias humanas que no encajan en la curva de Gauss. Necesitamos jueces formados en literatura, en psicología profunda y en ética aplicada, capaces de detectar cuándo la “solución lógica” que propone la máquina es, en realidad, una abominación moral. La competencia clave ya no es la erudición legal, sino la resistencia cognitiva: la capacidad de decir “no” a la sugerencia algorítmica, de detener la cinta transportadora de sentencias y exigir ver al ser humano detrás del número de expediente.

La Última Trinchera: El Dolor como Verdad

Finalmente, debemos abrazar la paradoja de que nuestra mayor debilidad es nuestra mayor fortaleza. La IA no puede “comprender” el castigo porque no puede experimentar la privación de libertad. No entiende la angustia de una multa, la vergüenza de la exposición pública o el dolor de la separación familiar. Simplemente, optimiza variables.

El juez humano, en cambio, actúa como un transductor biológico de la realidad. Su “ineficiencia” es, de hecho, un proceso de validación emocional. Cuando un juez dicta sentencia, debe sentir, aunque sea mínimamente, el peso gravitacional de sus palabras. Ese peso, esa carga que dobla los hombros del magistrado, es la única garantía de que la sentencia no es gratuita.

Si eliminamos el sufrimiento del proceso de juzgar —si hacemos que dictar una cadena perpetua sea tan fácil y rápido como hacer un clic en una pantalla— habremos cruzado el umbral hacia la barbarie tecnocrática. La justicia debe dolerle a quien la imparte para ser justa con quien la recibe.

En este nuevo mundo radicalmente diferente, dejemos que las máquinas calculen, predigan y organicen. Pero reservemos celosamente, como un territorio sagrado e inviolable, el derecho exclusivo a la compasión, a la duda tortuosa y, sobre todo, a la mirada humana que, al reconocer la fragilidad ajena, reconoce también la propia. Ese, y no otro, es el verdadero espejo en el que debemos mirarnos.

Por Marcelo Lozano – General Publisher IT CONNECT LATAM

Lea más sobre Análisis de datos e IA

- Google Vids: talento y la Narrativa Corporativa 2026

- Revolución de la Agencia Artificial: nuevo paradigma productivo 2025

- Gemini 3: El Manifiesto del Nuevo Orden Cognitivo

- ¿Democracia o control algorítmico? El poderoso siglo 21 ya llegó

- LIBRO 2025: La era de la inteligencia artificial y nuestro futuro humano es esencial

justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia, justicia,